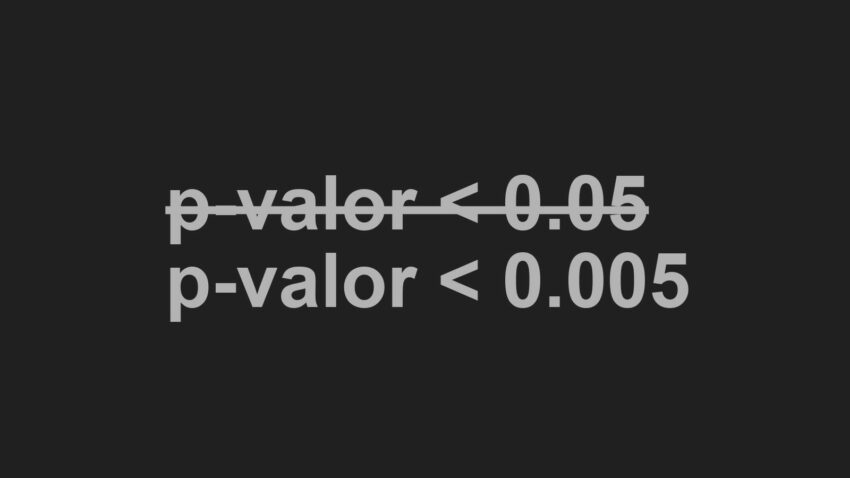

Setenta y dos investigadores, algunos de ellos auténticas referencias en sus respectivos campos, como John P. A. Ioannidis o Kenneth A. Bollen, firman este artículo en que proponen redefinir el umbral de significación estadística, pasando del tradicional 0.05 a 0.005, es decir, 10 veces más exigente.

Para justificar su propuesta se basan principalmente en el argumento de la carencia de reproducibilidad de estudios en las ciencias sociales y biomédicas. Aunque es cierto que problemas como los múltiples test, el p-hacking, la poca potencia o el sesgo de publicación siguen siendo relevantes, abogan porque la causa capital ese esa carencia es agarrarse irremisiblemente a un p-valor de 0.05 que Roland Fisher escogió arbitrariamente. Para nuevos descubrimientos (no consideran la replicación de estudios existentes) 0.005 sería el umbral para rechazar la hipótesis nula.

El artículo tiene un tufillo eminentemente bayesiano, probablemente porque muchos de los firmantes prefieren este enfoque, en lugar del frecuentista. Así, no es de extrañar que se tome el factor de Bayes (BF) como patrón para el cambio propuesto.

Recordemos que la visión frecuentista de la probabilidad nos dice P(D|H0), es decir, dado que la hipótesis nula es verdad (se asume de partida), nos indica la probabilidad de los datos observados. Cuando esa probabilidad es muy pequeña, por debajo de 0.05, entonces se entiende que hay evidencias para no aceptar Ho.

Sin embargo, bajo la óptica bayesiana, tenemos P(H0|D), es decir, podemos calcular la probabilidad de la hipótesis de partida en función de los datos observables, algo que, al menos a primera vista, parece mucho más intuitivo.

Así, realizar esta operación P(H1|D)/Pr(H0/D) nos indica el ratio entre la probabilidad de la hipótesis alternativa (usualmente que existe un efecto distinto de cero) y la hipótesis nula (usualmente que no existe efecto). Pero claro, la aparente ventaja de esta perspectiva (sin duda más lógica) es que para calcular ambas probabilidades necesitamos estipular unas probabilidades para la H1 y la H0, es decir, unos priors, en lenguaje bayesiano, algo que en este artículo no se discute pero que ha llenado páginas en revistas científicas sobre la idoneidad de incluir la subjetividad (aunque algunos lo llaman información a priori) en la realización de un contraste de hipótesis.

El BF sólo tiene en cuenta la verosimilitud de los datos dadas las hipótesis: BF=f(D|H1)/f(D|H0), aunque esta definición es un tanto “incompleta” porque realmente es un elemento para actualizar los priors, es decir, el conocimiento a priori. De este modo; Posteriors = Priors * BF, es decir, se necesita establecer unos priors para obtener lo que estamos buscando que es : P(H1|D)/Pr(H0/D)

En las condiciones que relatan los autores en el artículo, existe una relación entre este indicador y el p-valor. Así, a un p-valor de 0.05 le correspondería un BF entre 2.5 y 3.4, algo que los autores consideran muy poco exigente.

Sin embargo, un umbral de 0.005 tendría su correspondiente BF entre 14 y 26, es decir, entre 14 y 26 veces en favor de la H1, la hipótesis alternativa, una evidencia bastante fuerte. Además, reduciría el número de falsos positivos. Los autores indican que hay evidencia de que el ratio de replicación es superior en estudios con niveles de significación por debajo de 0.005 que aquellos que están entre 0.005 y 0.05.

Los autores reconocen varias objeciones a su propuesta, entre ellas que el ratio de falsos negativos sería alto; no obstante, si el p-valor está entre 0.005 y 0.05 se podría considerar como “sugestivo”, es decir, como una especie de alerta de que se debe acumular más evidencia para rechazar o no la H0. Siendo realistas, los tamaños de muestra necesarios para detectar efectos en el umbral de 0.005 serían considerablemente mayores, lo que supone una barrera en investigación social y biomédica.

Limitaciones/Comentarios

En 2013, el investigador Valen E. Johnson, propuso una idea similar en la revista PNAS; bajar el nivel de significación a 0.005 o incluso 0.001, también justificándolo con el BF. Para ello se asumen que los priors de H1 y H0 son iguales (0.5) y que no hay subjetividad en la determinación de la hipótesis nula.

Los autores citan este estudio de Johnson y ofrecen una visión parecida, quizá reforzada por el hecho de la cantidad de investigadores firmantes.

Hay que enfatizar que el incremento de exigencia del nivel de significación no debe tapar los problemas de diseño metodológico y de análisis estadístico que son comunes en muchas investigaciones científicas, pero este hecho, por sí solo, ya ofrece quizá más garantías de que se van a reducir los falsos positivos.

Creo que todos los investigadores deberíamos pensar en esta propuesta. Personalmente, no santifico en absoluto el 0.05, y por mi experiencia creo que se debería ser más exigente principalmente al trabajar con muestras pequeñas, tal y como sostiene esta investigación. Para ello, hemos de esforzarnos en realizar diseños adecuados, obtener muestras más grandes, y ser cautos en las conclusiones.

Sin embargo no debemos obviar que aunque este gran número de investigadores se haya posicionado de esta manera, no dicen nada acerca de otros muchos que se niegan a ver las cosas de ese modo. De hecho, este no es un debate nuevo, ni mucho menos. Particularmente no estoy convencido de que la perspectiva bayesiana sobre la que los autores basan su razonamiento sea adecuada. ¿Qué pasaría con el establecimiento de otros priors? ¿Cuál sería entonces el nivel de significación recomendado?

Es más, poner un punto de corte en 0.005 sigue siendo peligroso en el sentido de pensar en decisiones dicotómicas (acepto/rechazo) que son científicamente más débiles que la continua evaluación de la evidencia.

Lo que sucede es que los “policy makers” necesitan un criterio para tomar decisiones, y es ahí donde los puntos de corte (con más o menos fortuna) son más necesarios. Sin embargo, los investigadores deberíamos tener la mente más abierta y no ser presos de un número que no es ningún Santo Grial, sino sólo una ayuda para el análsis. Eso sí, y quiero dejar esto claro, esto no significa que se deba prestar poca atención a la estadística, todo lo contrario, se necesita mucha destreza y transparencia para analizar correctamente los datos (por ejemplo, con test de mala especificación), y una vez que todo está bien sustentado entonces interpretar el nivel de significación correspondiente, con todos sus complementos necesarios (tamaño de efecto, intervalos de confianza, etc.). Poner poca atención en la estadística con la excusa de que el p-valor es arbitrario es un error garrafal.

No seamos esclavos del p-valor y admitamos que, como bien dicen los autores, una investigación donde no se encuentran efectos debería ser igualmente publicable. Pero hay que ser certero y preciso con los análisis estadísticos, algo por lo que todos los investigadores deberíamos trabajar día a día para mejorar nuestros conocimientos.

Benajmin, D. J. et al. (2017). Redefine statistical significance. Nature Human Behavior. Forthcoming